【情報理論】Shannonの情報エントロピー

【情報理論】Shannonの情報エントロピー

■概要

ここでは、Shannonの情報エントロピーについて簡単に解説する。内容はとても平易であるはずであり、指数・対数の学習にも適しているのではないかと思う。

始めに注意しておくが、この情報エントロピーと熱力学的エントロピーの間に安易な関連性を見出すことは危険である。この点については最後にも簡単に触れる。

■情報の性質

確率$p$で生じる事象の発生を観測することで得られる情報の尺度を考えたい(ここでは、確率をどう解釈するかということについては立ち入らない)。ここでいう情報とは、一般的に用いられる意味での情報とは異なっており、その事象の内容など細かな性質ではなく、それが起こるかどうかだけに注目したものである。すなわち、ここでいう情報とは、ある事象が生じたことの意外性のようなもの、あるいはそれを知ることによって減らせる不確実性の量のようなものだと思ってもらえればいい。

その場合の情報の尺度として、いくつか求められる性質がある。確率$p$で生じる事象を観測して得られる情報の量を$I$とすると

- 上述の意味での情報についていえば、マイナスの情報というものはないので、それは非負の(負ではない)値を取る:$I(p)\geq 0$

- もし必ず起こることがわかっている(生じる確率が$1$)なら、その事象が生じたことで得られる情報はないので、$I(1)=0$

- それぞれ確率$p_1$、$p_2$で起こる2つの独立な事象が生じたとき、それらが同時に起こる確率は$p_1 p_2$であるが、得られる情報は2つの情報の和なので$I(p_1p_2)=I(p_1)+I(p_2)$となる。

- 情報の測度は、確率の連続的な関数となる。

これらの性質を満たすのは\begin{align} \label{Ip} I(p)=-\log (p) \end{align}の形の関数であることがわかる。これを自己情報量という。

■情報の単位

次に、情報の単位について考えよう。例えば公平なコイントスの表裏のように、ある変数が$2$つの値しかとらないのなら、「そのどちらであるか」という1つの問いで答えを特定できる。もし変数が$2^2=4$個の値を取るなら2つの問いで答えを特定できる。$2^3=8$個の値を取るなら3つの問い、$2^n$個の値を取るなら$n$個の問いが必要となる。

つまり、$n$個の値を取る変数から、値を特定するのに必要な問いの数は \begin{align} \log_2 n \end{align} と求められる。改めて、2通りの選択肢から1つを特定するのに必要な問いは \begin{align} \log_2 2=1 \end{align} であり、これを、ビットという情報の単位として定義する。

すなわち、ある変数が$2$つの値しかとらないのなら、その値が特定されたときに得られる情報は1ビット。もし変数が$2^2=4$個の値を取るなら2ビット、$2^3=8$個の値を取るなら3ビット、$2^n$個の値を取るなら$n$ビットとなる。

■情報エントロピー

これまでの議論から、情報量の定義として(\ref{Ip})で底を2とした \begin{align}

I(p)=-\log_2 (p)

\end{align} がふさわしいということがわかる(以下、底は省略する)。

次に、ある情報源$X$から得られる情報の期待値を考える。例えば公平なサイコロの目を$X$とすると、どの目も出る確率は$p_i=1/6 \ (i=1,...,6)$なので、得られる情報の期待値は \begin{align} H(X) = 6\times\left( -\frac{1}{6}\log\frac{1}{6}\right) = \log 6 \end{align} となる。

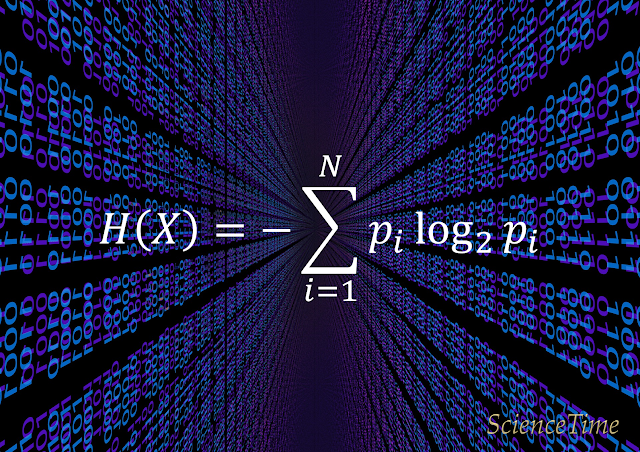

一般に、情報源(あるいは確率変数)$X$が提供する$N$個の独立な事象の集まり(あるいは確率変数の値)があり、それぞれの事象が起こる確率を$p_1,p_2,...,p_N$とすると、$X$から得られる平均情報量は、各情報量が$-\log p_i$なので \begin{align} H(X)=&p_1(-\log p_1) + p_2(-\log p_2) +...+ p_N(-\log p_N)= \notag \\ \label {H} =&-\sum_i p_i \log p_i \end{align} となる。 この平均の情報量(\ref{H})を、Shannonのエントロピーと呼ぶ。

■注意:熱力学的エントロピーとの関連性

改めて注意であるが、Shannonのエントロピー(\ref{H})を連続的な形にしたものはGibbsのエントロピーと同じ形をしているし、ある種の条件下で熱力学的エントロピーとのつながりがあることも実際に示されている。しかし、これらの間により一般的な関係があることを安易に想定するべきではない。

詳細はここでは議論しないが、Gibbsのエントロピーに現れるアンサンブルという仮想的な存在についての確率密度をどう解釈するかということや、そもそも統計力学における確率という概念をどう考えるかということについても未だに論争があり、熱力学的エントロピーの基本的な定義としてGibbsのエントロピーの定義を用いることの正当性に懐疑的な立場も根強い。また、Gibbs-Shannonエントロピーは、物理的な現象が観測者に本質的に依存するといった解釈を導きやすいため、(仮にそのような立場を支持するにしても)慎重に扱う必要がある。

検索用:クロード・シャノン

コメント